Ethical Bias Check

Dans le meilleur des cas, l'IA vous aide à mieux comprendre vos clients et vous apporte une vraie valeur ajoutée lors de chaque interaction. Mais malgré toutes vos bonnes intentions, certains facteurs de biais comme l'âge, le sexe ou l'appartenance ethnique ont une fâcheuse tendance à se glisser dans vos calculs. Résultat : vos analyses sont faussées, vous contrevenez involontairement à la réglementation et votre engagement client est fondé sur des critères de discrimination. Pis, vous perdrez la confiance du public.

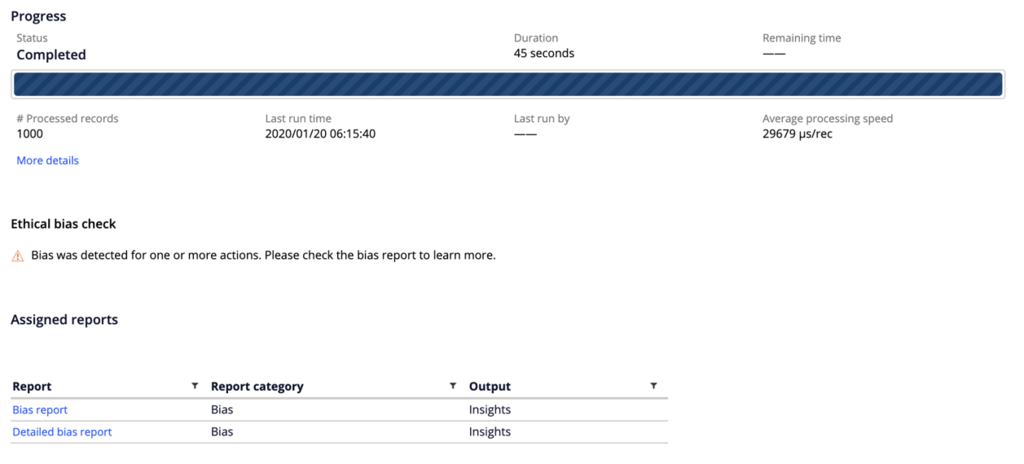

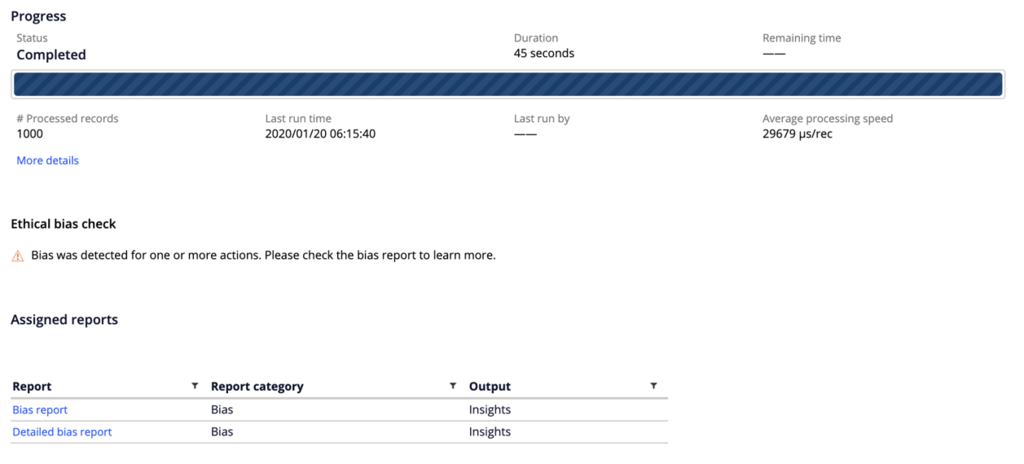

Avec la solution Ethical Bias Check de Pega, vous pouvez éviter les écueils de l'IA en détectant automatiquement les biais sur lesquels vos stratégies next-best-action sont fondées. Vous pouvez alors modifier la règle métier ou l'algorithme fautif pour obtenir des analyses plus équilibrées et plus équitables.

Lutter contre les biais : une formule plus simple qu'il n'y paraît

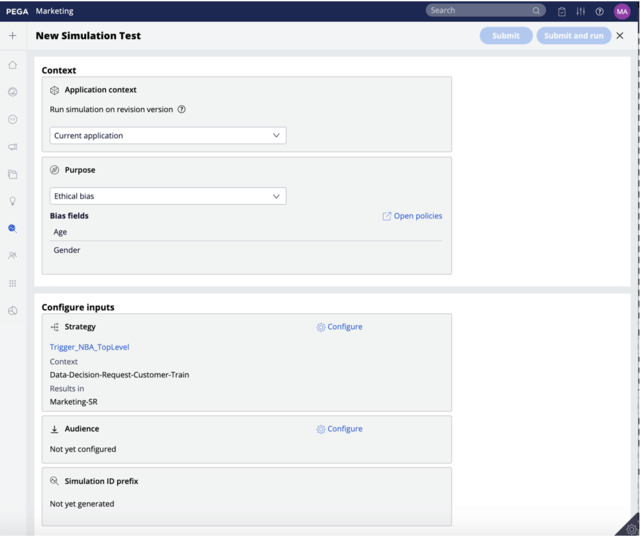

Développer et exécuter des tests de biais pour chaque aspect de chaque stratégie n'est pas nécessairement compliqué ou fastidieux. Pega analyse d'emblée l'intégralité de la stratégie d'engagement sur tous les canaux, ce qui vous fait gagner du temps et évite bien des erreurs.

Protection continue

Lutter contre les biais des algorithmes demande des efforts soutenus. La solution déployée doit donc être active en permanence. Intégrez le test des biais aux fonctionnalités standard de votre plateforme lors de la simulation des résultats stratégiques.

Une solution flexible contre les biais

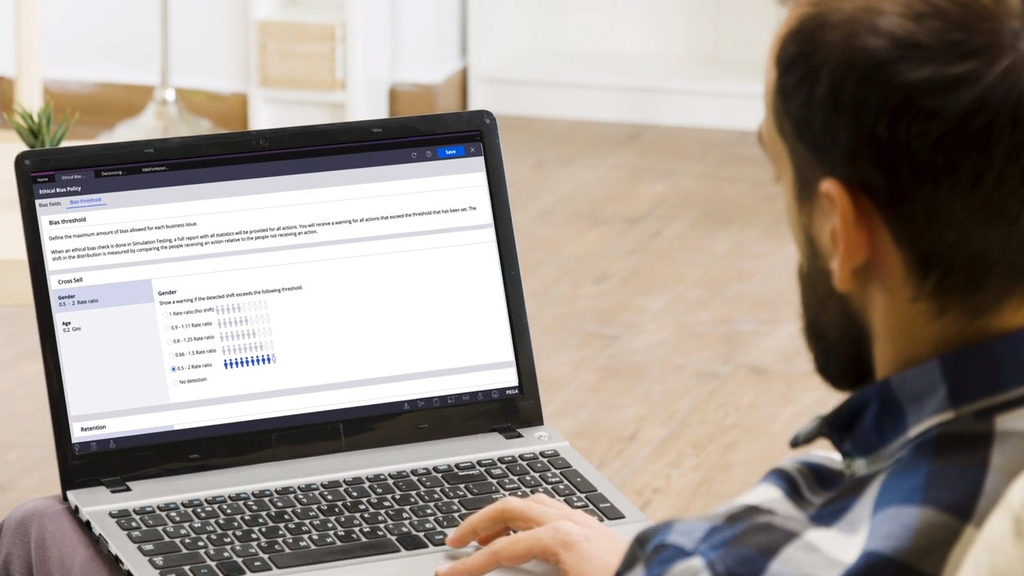

Ethical Bias Check permet de configurer les seuils de reporting, de notification et d'alerte. Vous pouvez élargir ou restreindre les conditions vous permettant de vous assurer que chaque aspect de votre stratégie est fondé sur des valeurs de performance et d'impartialité.

Ressources associées

-

Bold Stories Future Focused – AI Ethics and Immersive Technology

-

Proactively detecting and reducing AI bias | Pega